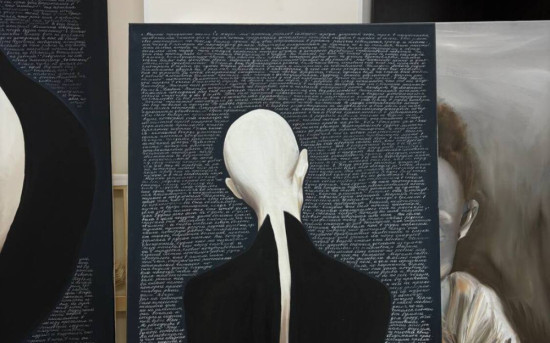

«ИИ-психолог»: где кончается машина и начинается человек

Мнение и практические рекомендации психологов сервиса YouMi — глубокий, практический и научно обоснованный разбор того, что сегодня реально может сделать ИИ

Исследователь в сфере психологического здоровья

Коротко — тезис о главном

ИИ-инструменты уже улучшают доступ к помощи (скрининг, триаж, поддержка, когнитивно-поведенческие модули), но они не заменяют человека там, где нужны эмпатия, клиническая оценка сложных рисков и этическое суждение. Правильная цель — строить сервисы с участием человека (human-in-the-loop) сервисы, где ИИ расширяет возможности психотерапевта и HR, а не вытесняет их.

Что уже умеют ИИ-психологи (и что доказано)

- Скрининг и триаж. Модели быстро обрабатывают анкеты, выявляют группы риска и направляют людей на нужный уровень помощи (самопомощь — консультирование — срочная клиника). Недавний обзор показывает широкую карту применения ИИ на этапах: скрининг, терапевтическая поддержка, мониторинг, образование и профилактика.

- Самопомощь и цифровая КПТ. Цифровые агенты и чат-боты, основанные на принципах КПТ, уменьшают симптомы тревоги/депрессии у выборок пользователей в ряде исследований и мета-анализов (эффект, как правило, небольшой-средний; лучше у легких–умеренных состояний).

- Психологическая поддержка 24/7. Чат-боты обеспечивают немедленную реакцию и часто удерживают пользователя, снижая барьер обращения за помощью. Это ценно там, где нет живого специалиста.

Но: качество исследований и их длительность сильно варьируют — многие позитивные эффекты краткосрочны, а систематические обзоры подчеркивают необходимость более строгих RCT (рандомизированное контролируемое исследование) и пост-маркетингового наблюдения.

Где ИИ терпит поражение — и почему это важно

- Кризисы и тяжелые психические расстройства. ИИ-боты плохо распознают и безопасно обрабатывают суицидальные мысли, психозы и сложные коморбидности; в клинике это может иметь смертельные последствия. По этой причине регуляторы и крупные системы здравоохранения предупреждают об ограничениях использования ботов как «замены» специалистов.

- Поддержание делюзий / усиление вредного контента. ИИ склонен «подстраивать» ответы под пользователя (включая подтверждение его убеждений) — в уязвимых случаях это может усиливать опасные идеи. Были задокументированы трагические случаи, когда взаимодействие с чат-ботом сыграло роль в ухудшении состояния.

- Неспособность читать невербальные сигналы. Живая клиническая сессия содержит тысячи невербальных подсказок — интонация, паузы, взгляд, телодвижения — которые важны для диагностики и эмпатии. Современный ИИ (даже с аудиовизуальным анализом) пока не воспроизводит полноту человеческого восприятия и интерпретации контекста.

Этические и регуляторные вопросы (с примерами)

- Прозрачность и ответственность. Кто несет ответственность, если ИИ-рекомендация навредила? Поскольку правовая база еще формируется, компании рискуют юридическими и репутационными последствиями без четких протоколов. Недавно ряд регуляторов в мире начали вводить ограничения и требования по прозрачности таких сервисов.

- Конфиденциальность данных. Психологические данные — особо чувствительная категория. Передача и хранение разговоров, метаданных и предсказаний требуют строгой защиты и понятных пользователю соглашений.

- Коммерциализация уязвимости. Монетизация через удержание/рекомендации (engagement optimisation) может вступать в конфликт с клиническими интересами пациента. Недавние тревожные публикации подчеркивают, что алгоритмы, оптимизирующие вовлеченность, не всегда служат здоровью человека.

Где заканчивается машина и начинается человек — практический градиент

Предлагаю смотреть не на «границу» как на четкую линию, а как на шкалу ролей:

- Автоматические (машинные) задачи — скрининг, первичный триаж, напоминания, короткая психообразовательная КПТ-поддержка, мониторинг симптомов дистанционно. Здесь ИИ уже дает реальную ценность.

- Гибридные задачи (машина + человек) — подготовка к терапии (анкетирование, сбор анамнеза), помощь терапевту в формировании гипотез, рекомендации по планам наблюдения, автоматическое выявление ухудшений и эскалация к специалисту. Это «sweet spot»: эффективность + безопасность.

- Чисто человеческие задачи — оценка сложных случаев, работа с травмой и межличностной динамикой, установление и поддержание глубокой эмпатии, вмешательства при суицидальном риске, решения этического характера. Здесь роль терапевта центральна и незаменима.

Как YouMi строит безопасный и эффективный сервис «ИИ + человек» — практические рекомендации

Ниже — рабочая архитектура и набор протоколов, которые мы бы внедрили как сервис онлайн-психологов.

1) Архитектура сервиса — «три уровня»

- Уровень A (самопомощь + чат-бот): психообразование, дыхательные практики, короткие КПТ-модули, неотложные инструкции. Риск низкий, польза — высокий охват.

- Уровень B (гибридный): ИИ делает скрининг/GAD-7 (Generalized Anxiety Disorder-7) — шкала генерализованного тревожного расстройства, 7 пунктов и PHQ-9 (Patient Health Questionnaire-9) — шкала депрессии, 9 пунктов, готовит краткий досье для терапевта, отслеживает приверженность терапии и сигналит о рисках. Человек принимает окончательное решение.

- Уровень C (клинический): живая сессия со специалистом, супервизия, направление в стационар при необходимости.

Каждое переключение на более высокий уровень должно сопровождаться четким триаж-протоколом и человеческой верификацией

2) Принципы безопасности и качества

- Human-in-the-loop (HITL): любые клинически значимые решения требуют подтверждения специалистом.

- Протоколы эскалации: мгновенная передача вживую при суицидальных сигналах; доступ к экстренным контактам/службам.

- Валидация и исследование: обязательные RCT и длительное пост-маркетинговое наблюдение для любых клинических заявлений.

- Прозрачность для пользователя: открыть, что отвечает — ИИ; какие данные собираются; как работает триаж; возможные ограничения.

3) Дизайн продукта

- Не маскируйте ИИ под человека. Пользователь должен всегда знать, что общается с ботом, а не «человеком». Это снижает риск неправильной интерпретации и этических проблем.

- Контекстуальная осторожность. Визуальная/аудио интеграция (если есть) использовать аккуратно — чтобы не создавать ложного впечатления о «понимании» ботом истинного состояния.

4) Метрики и контроль качества

- Клиничесные KPI: изменение PHQ-9/GAD-7 у пользователей; % переведенных в живую терапию; число ложноположительных/отрицательных триажей.

- Безопасность: число эскалаций, время реакции, инциденты с негативным исходом.

- Этические метрики: прозрачность согласий, уровень доверия пользователей, доля тех, кто понимает работу ИИ.

Заключение — где мы и куда идем

ИИ уже делает реальные вещи: расширяет доступ, снижает барьеры и поддерживает рутинные процессы. Но там, где на кону — жизнь, сложная психопатология или глубокая межличностная терапия — роль человека остается центральной и незаменимой. Золотое правило будущего — не «машина вместо человека», а машина, которая делает человека лучше: быстрее замечать, точнее триажировать, глубже готовить и безопаснее сопровождать. Все продукты ментал-хелса, которые захотят жить долго и честно, будут строиться по этому принципу.

Интересное:

Новости отрасли:

Все новости:

Публикация компании

Контакты