Почему бизнес боится ИИ и что с этим делать

Разберемся, какие опасения мешают компаниям начать работать с ИИ и как с ними справляться

Вел ключевые проекты, лидировал направление системного анализа, выступал наставником, курировал построение системы ИБ компании. Драйвит освоение новых рынков и трансформацию компании. AI-евангелист

Обсуждение рисков искусственного интеллекта уже стало привычным. Негативных примеров хватает: алгоритмы могут давать неточные или спорные ответы, позволяют себе оценки, основанные на дискриминационных суждениях, и вообще могут просто подорвать репутацию бренда. Недавнее исследование Anthropic показало, что нейросеть можно «уговорить» высказаться на скользкие темы, если особым образом сформулировать вопрос. И это только один из факторов риска. В результате бизнесу «и хочется, и колется» — внедрять ИИ-инструменты нужно, но при этом страшно рисковать. Разберемся, какие опасения мешают компаниям начать работать с ИИ и как с ними справляться.

Главный страх — безопасность данных

Крупный аргумент против ИИ — риск утечек. Компании боятся доверять свои данные облачным сервисам, ведь информация хранится на сторонних серверах и может оказаться в чужих руках. Чем с более чувствительными данными работает бизнес, тем больше сомнений.

Эта проблема затрагивает как внутренние данные, на которых обучается LLM, так и внешние, которые передают пользователи. Например, клиент делится с чат-ботом конфиденциальной информацией, чтобы получить помощь. Если есть даже минимальный риск утечки, бизнес зачастую отказывается от использования ИИ.

Решение — использовать ИИ в закрытом контуре компании. Но это требует серьезных инвестиций в инфраструктуру. Если компания выбирает не open-source, а проприетарное решение, затраты возрастают еще сильнее. Поэтому локальные нейросети пока что чаще встречаются у крупных игроков.

Этика ответов: не навредит ли ИИ

Бизнесу важно, чтобы отвечая клиентам, искусственный интеллект оставался в рамках — например, не врал. Проблема в том, что нейросети иногда «придумывают» факты, выдавая за правду то, что нашлось в обучающем материале. Подобные случаи вызывают критику и вредят репутации компании. Клиент не будет разбираться, что это единичная ошибка ИИ — он видит ошибку бренда.

Кроме того, AI может предвзято трактовать информацию. Например, исследование Bloomberg показало, что на запросы «юрист», «политик» или «CEO» генеративный ИИ чаще выдает изображения мужчин. Несложно понять, откуда ветер дует — языковые модели обучаются на большом объеме реальных «человеческих» данных — а они полны таких искажений.

Это подтверждает кейс Amazon, где AI-инструмент для найма при отборе кандидатов на технические вакансии отдавал предпочтение мужчинам, так как обучался на исторической базе резюме, где доминировали мужчины.

Учитывая новые этические стандарты, последствия могут быть плачевными.

Как не попасть в скандал

Когда компания внедряет AI-ботов в клиентскую поддержку, важно следить, чтобы их ответы соответствовали корпоративному тону. Были случаи, когда чат-боты выдавали провокационные ответы, которые быстро разлетались по соцсетям, нанося удар по репутации бренда.

Однажды голосовой помощник N на вопрос ребенка о «Маше и медведе» выдал жуткий ответ, будто Маша — это призрак убитой девочки. И убил ее сам медведь. История быстро разошлась в интернете, и компании пришлось публично объясняться. Скорее всего языковая модель «нашла» эту версию где-то на просторах интернета. Чтобы избежать таких ситуаций, бизнесу нужно ограничивать доступ ИИ к неофициальным источникам и задавать четкие рамки общения.

С клиентом из финтеха мы обсуждали автоматизацию поддержки, и партнеры беспокоились, не станет ли бот обсуждать экономическую ситуацию в стране. Ну например, клиент спросит у ИИ-бота «Почему доллар такой дорогой?», и тот даст компрометирующий компанию ответ. Бизнесу важно, чтобы ИИ не позволял себе лишнего — использовал данные из строго ограниченной базы знаний и делал это в соответствии с Tone of Voice компании.

Свободные сценарии и способность поддержать смолток — это здорово с точки зрения пользовательского опыта, но серьезный риск для репутации компании. К тому же случайные пользователи часто специально провоцируют ботов дать остросоциальный или политический комментарий, чтобы выложить потом скриншот в сеть. Разбираться с последствиями и прямыми репутационными потерями для бизнеса — довольно дорогое занятие. Особенно если скриншот «завирусился».

При внедрении AI-ассистентов важно четко определять их рамки знаний, обучать их только на проверенных данных и периодически проводить тестирование на провокационные запросы.

Галлюцинации ИИ: когда нейросеть фантазирует

ИИ может выдавать неточные или вымышленные факты — «галлюцинировать». Адвокат из США использовал ChatGPT для подготовки иска, не проверил ссылки на судебные дела — а те оказались фейковыми. Итог — штраф.

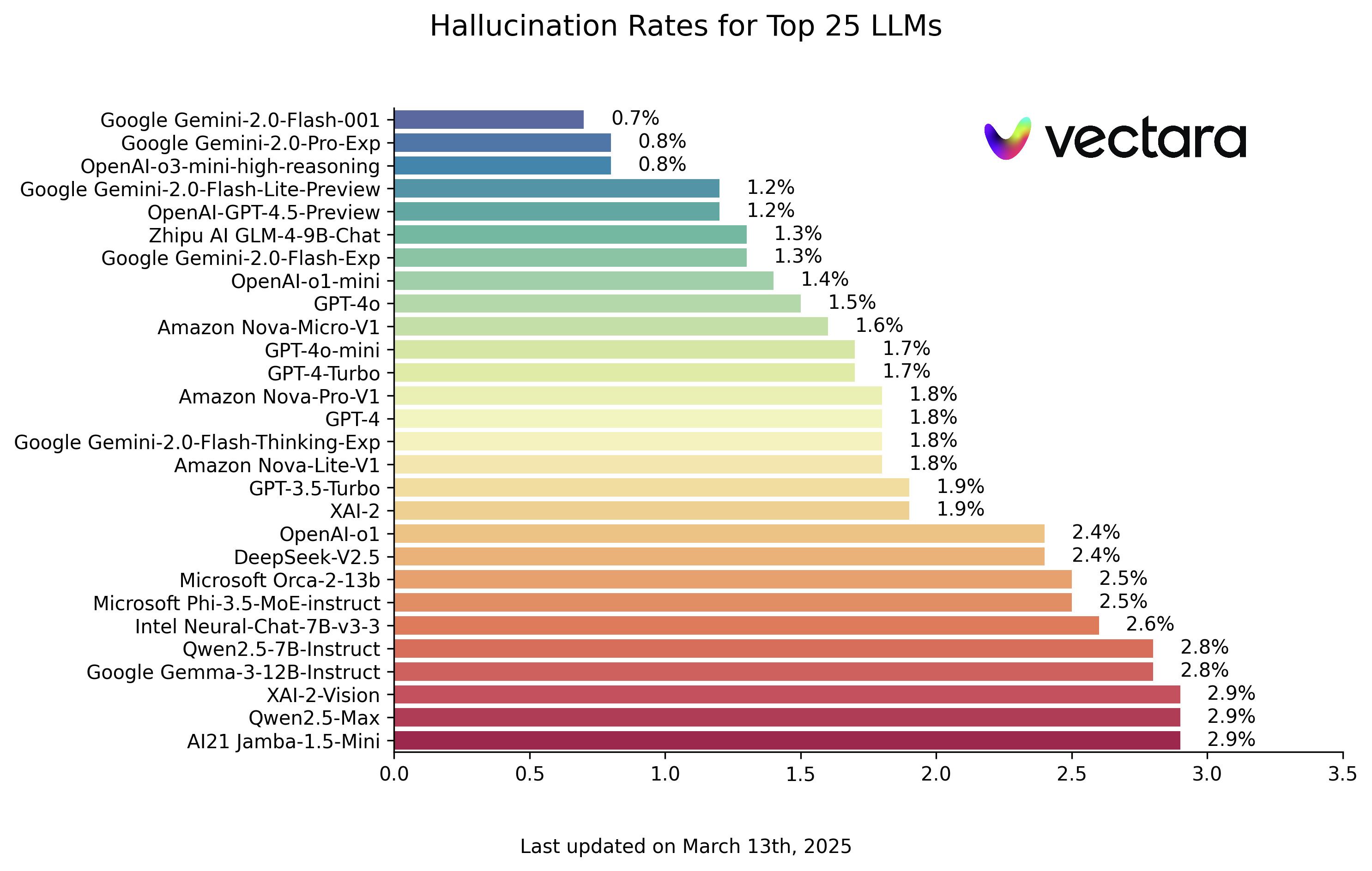

Стартап Vectara проанализировал работу популярных LLM и выявил, что у 25 лучших моделей частота галлюцинаций варьируется от 1,3 % до 4,2 %, а у менее популярных — до 29,9 %! Для бизнеса даже небольшой процент таких ошибок может быть критичным.

Галлюцинации могут появляться не только в текстах, но и в изображениях. Изображения людей с шестью пальцами или другими странностями в анатомии — уже классика. На одном из наших проектов мы генерировали изображения блюда с креветками, и нейросеть добавила креветке два хвоста. Этот случай был скорее забавным, но несложно смоделировать ситуацию, в которой ошибка может стоить компании репутации.

Как минимизировать риски

Есть несколько способов снизить вероятность ошибок:

- Ограничить нейросеть в доступе к данным, обучая ее только на качественных проверенных источниках.

- Настроить правила, по которому если ИИ не знает ответа, он должен сказать об этом, а не додумывать.

- Тестировать систему миллионами запросов, чтобы выявить слабые места.

- Использовать ИИ-контроль: одна нейросеть проверяет ответы другой. Например, в «Альфа-Банке» так повышают скорость и достоверность решений по кредитам.

Разработчики ИИ стараются минимизировать риски за счет специальных алгоритмов, которые помогают отслеживать токсичность и недостоверность информации. В компаниях обучают и тестируют модели на базе собственных данных, проверяют их на больших объемах запросов, анализируют ошибки и устраняют проблемные моменты.

Что в итоге?

ИИ — мощный инструмент, но его использование требует осторожности. Пока бизнес опасается утечек, некорректных ответов и галлюцинаций нейросети, разработчики ищут способы минимизировать риски. Полностью исключить ошибки невозможно, но ведь и люди не всегда принимают верные решения. Главное — выстраивать работу с ИИ так, чтобы его ошибки не становились проблемой для бизнеса и клиентов.

Компании, которые хотят внедрять ИИ, должны быть готовы к дополнительным затратам на его адаптацию, проверку и контроль. Однако если подойти к процессу осознанно, выгода от использования ИИ может многократно окупить все вложения.

Источники изображений:

Vectara / Github

Интересное:

Новости отрасли:

Все новости: