Какие SEO ошибки мешают сайту расти в поиске: часть 1

Технические проблемы и ошибки в контенте: как их исправить и повысить позиции в поисковой выдаче

Частный SEO-специалист, эксперт в области SEO-продвижения сайтов.

Рост сайта в поисковых системах может быть ограничен из-за множества ошибок. От технических проблем до ошибок в контенте и ссылках — каждая из них может стать преградой. В этой статье разберем основные из них.

Технические ошибки

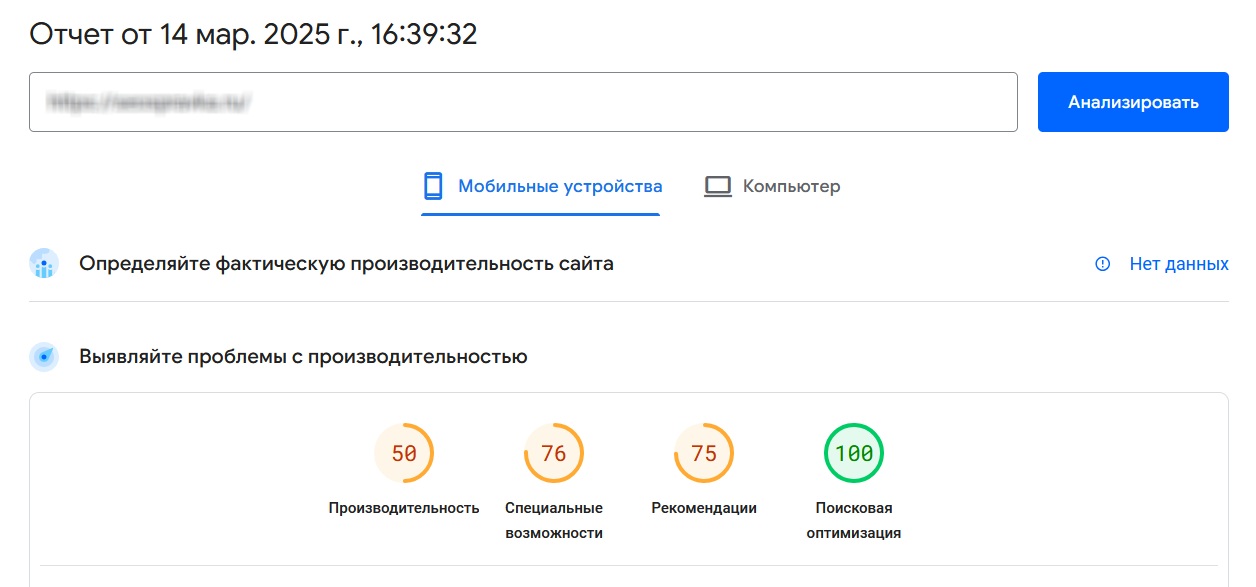

1. Медленная загрузка сайта

Если сайт загружается слишком долго, поисковые системы могут понизить его в результатах выдачи. Причина проста: поисковики стремятся предлагать своим пользователям только самые полезные и качественные ресурсы, которые максимально соответствуют их запросам и быстро предоставляют нужную информацию.

Когда пользователь заходит на медленный сайт, вместо контента он видит бесконечно крутящееся колесо загрузки. Это вызывает раздражение и недовольство, что негативно сказывается на пользовательском опыте. Поисковая система замечает, что посетитель быстро покидает ваш сайт и возвращается к результатам поиска. Это сигнализирует о том, что ресурс не смог удовлетворить потребности пользователя, а значит, его полезность ставится под сомнение. В результате сайт теряет позиции в выдаче.

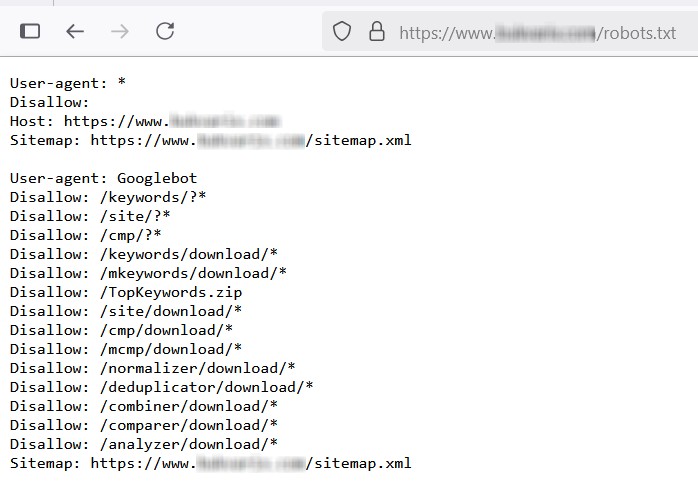

2. Ошибки в robots.txt

Неправильная настройка файла robots.txt может привести к серьезным проблемам с индексацией сайта. Например, поисковые роботы могут быть лишены доступа к важным страницам, которые должны участвовать в поисковой выдаче. В результате такие страницы просто не будут отображаться в результатах поиска, даже если они содержат полезный и релевантный контент.

С другой стороны, в файле robots.txt могут быть открыты для индексации технические, вспомогательные или даже конфиденциальные страницы, которые не должны быть доступны для поисковиков. Это может привести к утечке служебной информации или появлению в выдаче мусорных страниц, что негативно скажется на репутации сайта.

Кроме того, стоит обратить внимание на метатег robots, который также может влиять на индексацию страниц. С его помощью можно управлять доступом поисковых роботов к отдельным страницам.

Например, недавно я обнаружила, что в одном интернет-магазине более 1000 товаров были закрыты от индексации с помощью этого метатега. При этом товары были в наличии и готовы к продаже, но из-за ошибки в настройках они просто не могли быть найдены через поиск.

3. Дубли контента

Дублированный контент — это ситуация, когда на разных страницах или URL-адресах размещен одинаковый или очень похожий контент. Это может привести к снижению позиций сайта в поисковой выдаче, так как поисковые системы стремятся показывать пользователям уникальные и релевантные материалы.

Откуда берутся дубли?

- Создание страниц без учета SEO и кластеризации семантического ядра. Если разрабатывать страницы без участия SEO-специалиста и не проводить кластеризацию семантического ядра, можно случайно создать несколько страниц под один кластер запросов. В таких случаях возникает проблема каннибализации: страницы начинают конкурировать между собой, какая из них покажется в результатах поиска. В итоге ни одна из них не получает достаточного веса, что негативно сказывается на позициях.

- Страницы пагинации. Дубли часто возникают на страницах с пагинацией (например, «страница 1», «страница 2», «страница 3» и т.д.). Заголовки, метатеги и общее описание на таких страницах обычно одинаковые, а различия в контенте минимальны. Для поисковых систем это дубли, и чтобы избежать проблем, нужно использовать атрибут canonical, который указывает на основную страницу.

Недавно я столкнулась с интересной проблемой: на сайте в карточках товаров были кнопки «назад» и «далее». По какой-то причине эти кнопки создавали собственные URL-адреса — к основному URL карточки добавлялись параметры next и prev. В результате получилось множество мусорных страниц: одна карточка товара, но три URL (основной, с next и с prev). Это просто безумие!

Как избежать дублей?

- Все страницы сайта должны отличаться друг от друга метатегами и контентом.

- Нельзя плодить «однояйцевые» страницы — это плохая идея как для пользователей, так и для поисковых систем.

- Используйте атрибут canonical для указания основной версии страницы.

- Регулярно проверяйте сайт на наличие дублей с помощью инструментов вроде Screaming Frog, Яндекс Вебмастер или Google Search Console.

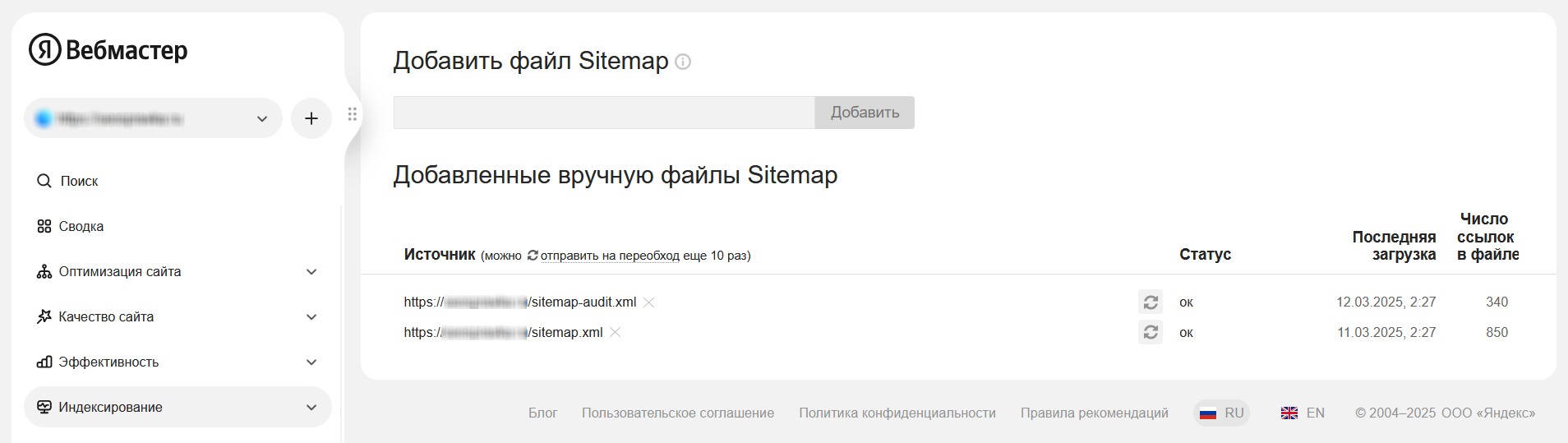

5. Ошибки в карте сайта (sitemap.xml)

Некорректная или устаревшая карта сайта может серьезно затруднить работу поисковых роботов и замедлить индексацию страниц.

Чтобы избежать проблем, важно соблюдать несколько ключевых правил:

- Карта сайта должна существовать. Без файла sitemap.xml поисковым роботам сложнее понять структуру сайта и найти все важные страницы.

- Она должна содержать все актуальные страницы. В карте сайта должны быть перечислены все страницы, которые вы хотите видеть в поисковой выдаче. Если какие-то страницы отсутствуют в sitemap.xml, они могут быть проигнорированы поисковыми системами.

- Она не должна содержать несуществующих страниц. Устаревшие или удаленные страницы, которые остались в карте сайта, могут запутать поисковых роботов и привести к ошибкам индексации.

- Карта сайта должна быть загружена в Яндекс.Вебмастер и Google Search Console. После создания или обновления sitemap.xml обязательно загрузите ее в инструменты для вебмастеров (Яндекс.Вебмастер и Google Search Console). Это поможет поисковым системам быстрее обнаружить и проиндексировать изменения на вашем сайте.

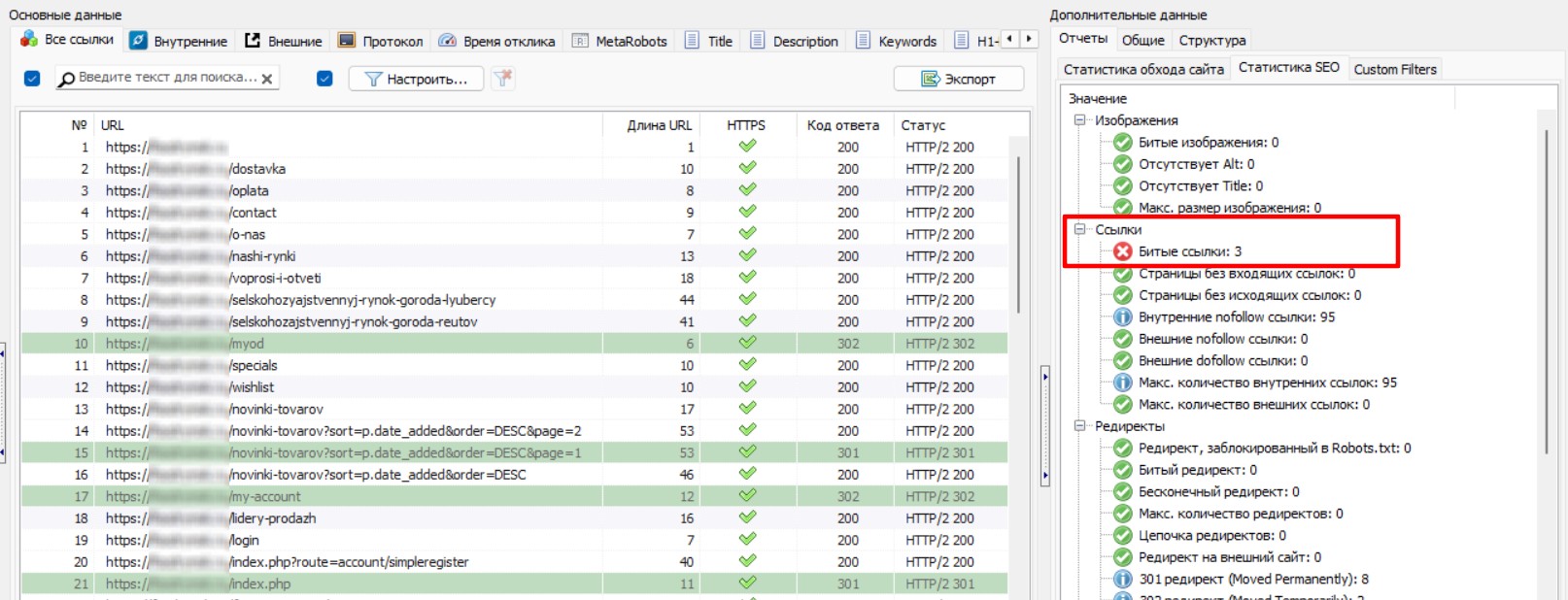

6. Битые ссылки и изображения (404 ошибки)

Битые ссылки и изображения — это серьезная проблема, которая негативно сказывается как на пользовательском опыте, так и на индексации сайта.

- Битые ссылки: это ссылки, которые ведут на несуществующие страницы. Пользователь, переходя по такой ссылке, видит ошибку 404.

- Битые изображения: это изображения, которые прописаны в коде страницы, но отсутствуют на сервере. Вместо картинки пользователь видит «пустое место» или иконку с ошибкой.

Почему это плохо?

- Для пользователей:

- Ошибки 404 и отсутствующие изображения создают негативное впечатление о сайте.

- Пользователи могут покинуть сайт, что увеличивает показатель отказов.

- Для поисковых систем:

- Поисковые роботы, натыкаясь на битые ссылки, тратят ресурсы впустую.

- Это может замедлить индексацию других страниц сайта.

Как найти и исправить?

- Регулярное сканирование сайта. Используйте инструменты для анализа сайта (например, Screaming Frog, SiteAnalyzer), чтобы находить цепочки редиректов и некорректные 301-редиректы.

- Оптимизация редиректов. Убедитесь, что каждый редирект ведет напрямую на конечную страницу, минуя промежуточные звенья. Проверьте, что 301-редиректы настроены только на релевантные и актуальные страницы.

- Регулярная проверка. Сканируйте сайт регулярно, особенно после внесения изменений в структуру или контент. Это поможет оперативно выявлять и устранять проблемы.

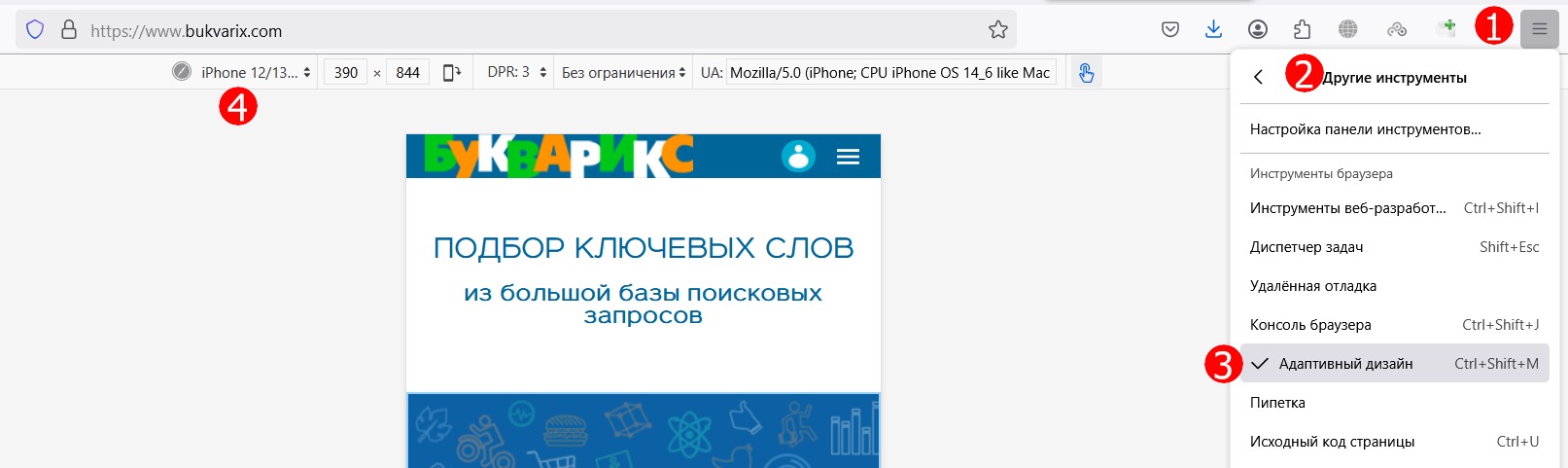

7. Проблемы с мобильной версией

Если сайт не адаптирован для мобильных устройств, это может серьезно снизить его позиции в поисковой выдаче, особенно с учетом mobile-first индексации.

Что значит «качественная мобильная версия»?

- Адаптивная верстка. Сайт должен корректно отображаться на экранах любых размеров, от смартфонов до планшетов.

- Удобство использования. Кнопки и ссылки должны быть достаточно крупными, чтобы их легко было нажимать. Шрифты должны быть читаемыми без необходимости увеличения. Навигация должна быть простой и интуитивно понятной.

- Быстрая загрузка. Мобильные пользователи часто используют мобильный интернет, поэтому сайт должен загружаться быстро даже при слабом соединении.

Что делать?

- Проверьте сайт с помощью инструментов, таких как Google Mobile-Friendly Test.

- Убедитесь, что все элементы сайта корректно отображаются на мобильных устройствах разных размеров.

- Оптимизируйте скорость загрузки, сжимая изображения и минимизируя код.

8. Некорректные редиректы

Цепочки редиректов или неправильно настроенные 301-редиректы могут серьезно затруднить индексацию сайта и ухудшить его позиции в поисковой выдаче.

Почему это проблема?

- Цепочки редиректов: когда одна страница перенаправляет на другую, та — на третью, и так далее. Это путает поисковых роботов и замедляет индексацию.

- Неправильные 301-редиректы: если страница перенаправляется на нерелевантный или ошибочный URL, это может привести к потере трафика и ухудшению пользовательского опыта.

Как это исправить?

- Регулярное сканирование сайта. Используйте инструменты для анализа сайта (например, Screaming Frog, SiteAnalyzer), чтобы находить цепочки редиректов и некорректные 301-редиректы.

- Оптимизация редиректов. Убедитесь, что каждый редирект ведет напрямую на конечную страницу, минуя промежуточные звенья. Проверьте, что 301-редиректы настроены только на релевантные и актуальные страницы.

- Регулярная проверка. Сканируйте сайт регулярно, особенно после внесения изменений в структуру или контент. Это поможет оперативно выявлять и устранять проблемы.

Ошибки в контенте

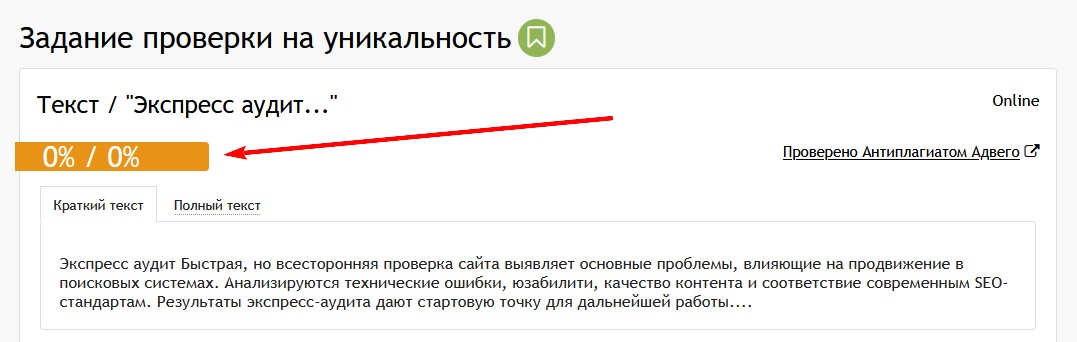

1. Некачественный или неуникальный контент

Поисковые системы высоко ценят оригинальный, полезный и качественный контент. Копирование текстов с других сайтов или публикация низкокачественных материалов может привести к санкциям со стороны поисковиков и снижению позиций сайта.

Каким должен быть контент?

- Уникальным в рамках всего интернета. Текст должен быть оригинальным и не скопированным с других ресурсов. Это важно для избежания санкций и повышения доверия со стороны поисковых систем.

- Уникальным в рамках вашего сайта. Даже внутри одного сайта контент не должен дублироваться. Как я уже писала выше, дубли страниц или текстов могут привести к канибализации и ухудшению индексации.

- Качественным и полезным. Контент должен отвечать запросам пользователей, быть информативным и хорошо структурированным.

Как проверить уникальность?

- Используйте инструменты для проверки уникальности текста (например, Advego, Text.ru, ETXT).

- Убедитесь, что уникальность текста составляет не менее 85%. Это минимальный порог, который гарантирует, что контент не будет считаться дублированным.

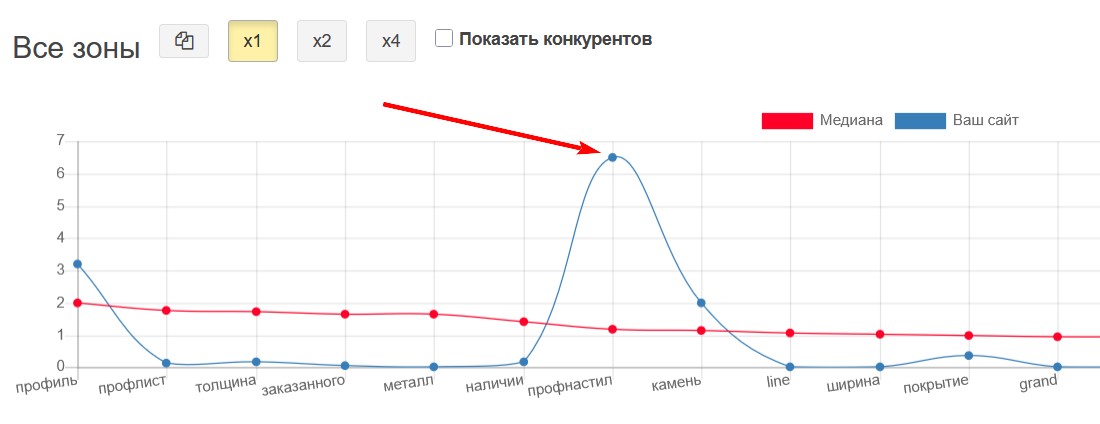

2. Переоптимизация

Злоупотребление ключевыми словами (переспам) может привести к понижению позиций сайта в поисковой выдаче. Поисковые системы стремятся показывать пользователям естественный и полезный контент, а не перенасыщенный ключевиками текст.

Переоптимизацию часто называют «тошнотой». Это как если бы вы переели орехов, и вас начало тошнить. Точно так же сайт, «объевшийся» ключевыми словами, становится неестественным и перегруженным, что вызывает «тошноту» у пользователей и поисковых систем.

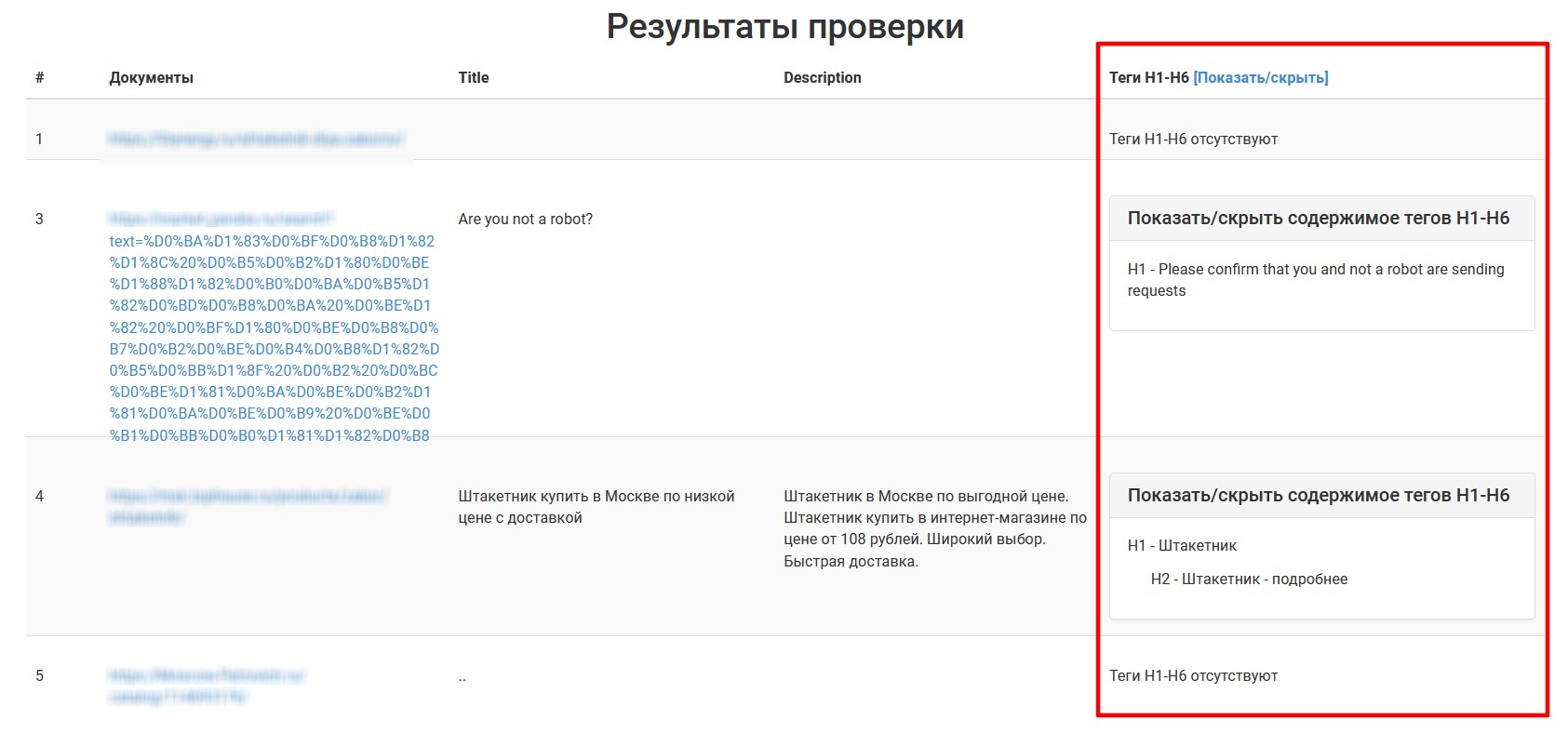

Пример переоптимизации

Недавно я столкнулась с примером переспама в интернет-магазине. В характеристиках товара (штакетника) вместо простого указания параметров (ширина, высота, толщина) было написано:

- высота штакетника,

- ширина штакетника,

- толщина штакетника.

На странице категории было 30 товаров, и слово «штакетник» повторялось настолько часто, что текст стал неестественным и перегруженным.

Где еще может скрываться переоптимизация?

- Скрытые элементы. Слова могут быть «зашиты» в исходный код страницы и скрыты от пользователя с помощью CSS. Это создает иллюзию оптимизации, но на самом деле вредит сайту.

Недавно я обнаружила, что самым частым словом на странице было слово «подробнее». При этом визуально на странице оно не отображалось ни разу! Оказалось, что верстальщикам было лень вычищать лишний код, и они просто спрятали ненужные элементы с помощью display: none;. В результате на странице появился скрытый мусор, который не только загромождает код, но и может навредить SEO.

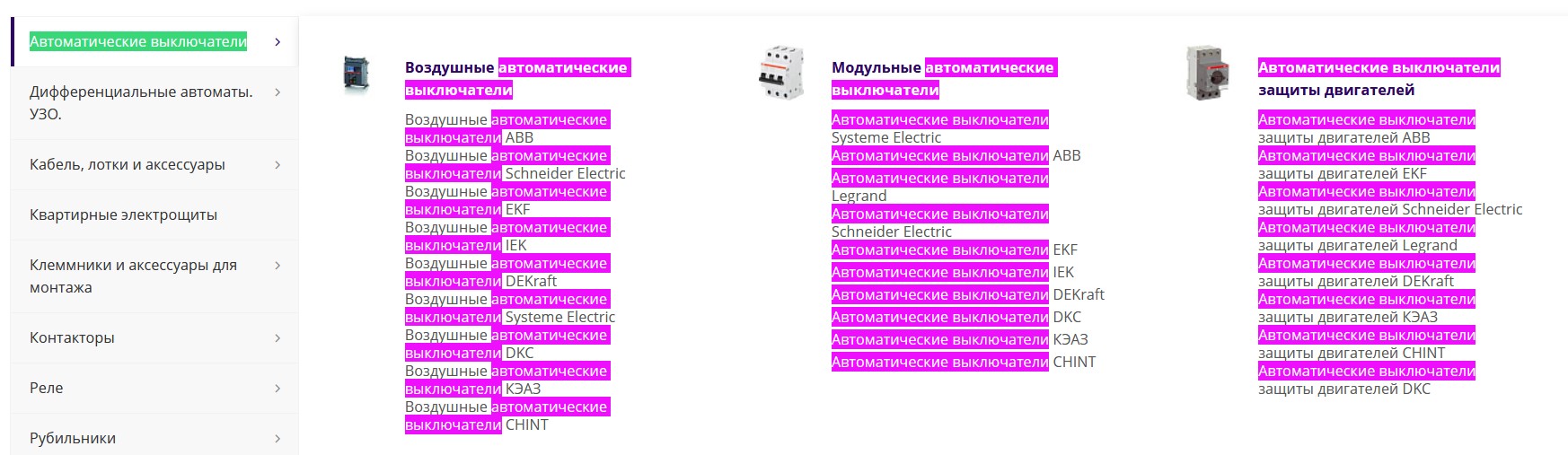

- Меню сквозное и дублирующееся. Частое явление — ключевые слова много раз повторяются в меню, которое дублируется в коде несколько раз:

- для десктопной версии,

- для планшетов,

- для мобильных устройств.

А затем еще и в футере, что добавляет четвертый дубль. В итоге ключевые слова повторяются десятки раз, что выглядит как явный переспам.

Скрытая угроза

Меню — это сквозной элемент, который присутствует на всех страницах сайта. И если в нем переспамить ключевыми словами, например, словом «штакетник», то все страницы сайта будут считаться релевантными именно этому ключу, а не своим уникальным запросам. Это настоящий эпик фэйл, друзья!

Как избежать переоптимизации?

- Пишите естественно. Используйте ключевые слова только там, где это уместно и не нарушает читаемость текста.

- Проверяйте исходный код. Регулярно анализируйте исходный код страниц, чтобы убедиться, что ключевые слова не дублируются в скрытых элементах.

- Оптимизируйте меню и футер. Убедитесь, что ключевые слова не повторяются в меню и футере многократно.

- Проверяйте сайт анализаторами текста. Эти инструменты покажут все слабые места и помогут сделать контент более качественным. Рекомендую: ГАР, Миратекст, Оверлид.

3. Отсутствие структуры контента

Неправильное использование заголовков (H1, H2 и т.д.), отсутствие списков или абзацев ухудшает читаемость текста и негативно влияет на SEO. Контент не должен быть «портянкой» — он должен быть удобным для восприятия и правильно организованным.

Основные правила структуры контента:

- Заголовки должны быть иерархичными:

- H1 — главный заголовок страницы. Он должен быть один и отражать основную тему.

- H2 — подзаголовки, которые раскрывают разделы темы.

- H3 и далее — подпункты внутри разделов.

- Используйте абзацы и списки:

- Разбивайте текст на короткие абзацы для удобства чтения.

- Добавляйте маркированные или нумерованные списки, чтобы упростить восприятие информации.

- Избегайте «портянок»:

- Большие блоки текста без структуры утомляют пользователей и снижают вовлеченность.

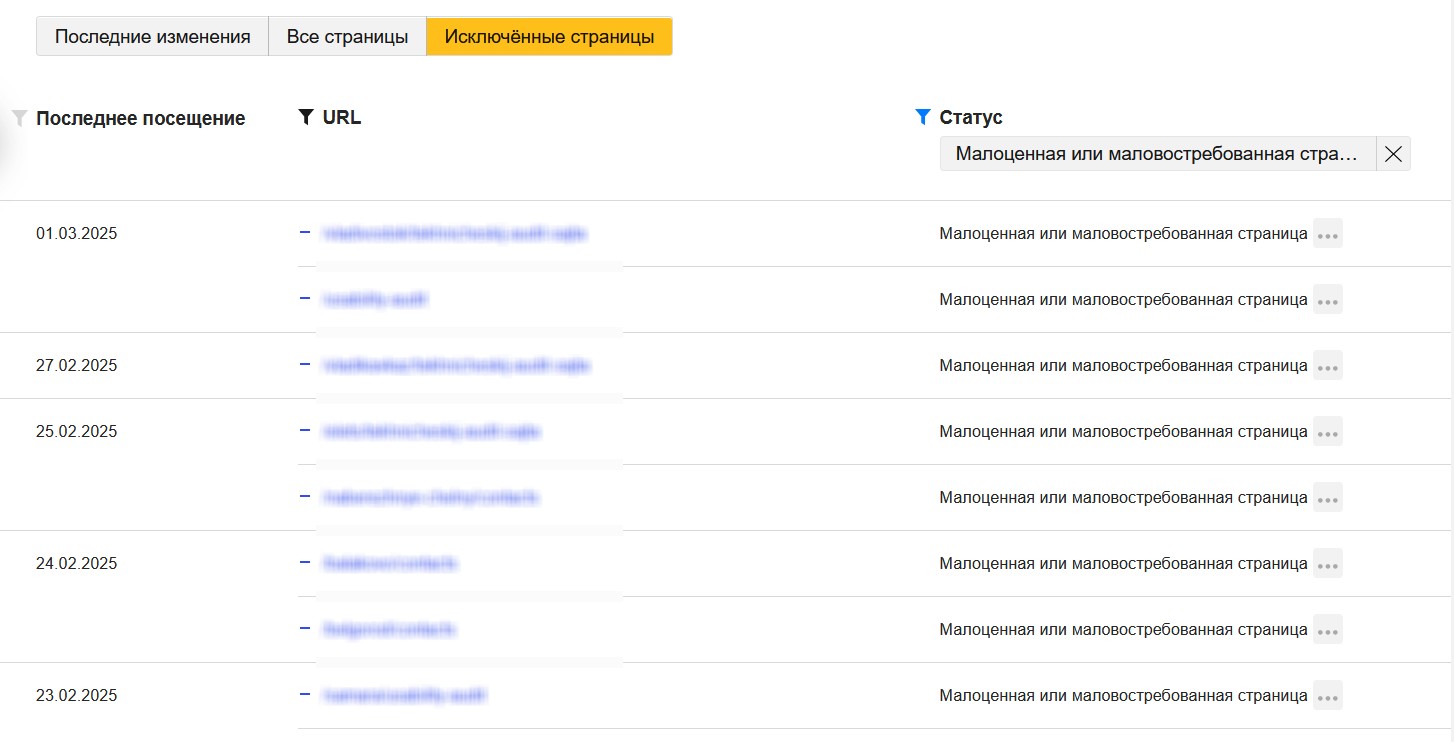

4. Мало текста на странице

Страницы с недостаточным объемом текста могут хуже ранжироваться в поисковых системах или даже не попасть в индекс. Например, такие страницы могут оказаться в разделе Яндекс.Вебмастера «Исключенные страницы».

- Мало текста = мало информации для понимания тематики страницы.

- Поисковики могут посчитать страницу нерелевантной или малополезной.

- Недостаток текста делает страницу менее информативной и полезной, что увеличивает вероятность отказов.

Не забывайте, что на каждой странице есть сквозные блоки (меню, футер, шапка), которые бывают довольно объемными. Если на самой странице текста мало, то уникальная часть становится слишком маленькой, и страница теряет свою ценность.

Продолжение следует…

В этой части я разобрала только часть ошибок, которые мешают сайту расти в поиске. Но их так много, что все не уместить в один материал. В следующих частях я продолжу рассказывать о других проблемах.

Источники изображений:

Валерия Цибикова

Интересное:

Новости отрасли:

Все новости:

Публикация компании

Профиль